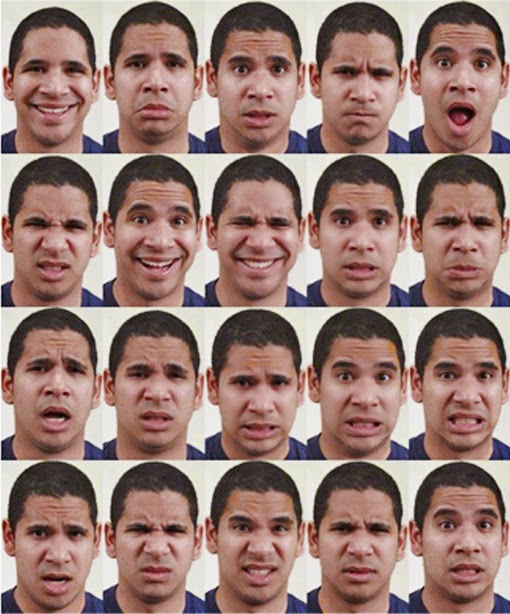

aus Die Presse, Wien, 1. 1. 2014 Von glücklich bis eingeschüchtert: 20 Gesichtsausdrücke.

Unsere Gesichter werden maschinenlesbar

Ein Computersystem kann einem schmerzverzerrten Gesicht ablesen, ob der Schmerz

echt ist oder nicht. Und falsches Lächeln entlarven. Aber wie viele

Gesichtsausdrücke gibt es eigentlich? US-Forscher unterscheiden 21.

Jeder gute Verkäufer liest seinem Kunden am Gesicht ab, was er noch gar nicht kaufen will, na ja, zumindest hält er das Gesicht im Blick, um die Kauflaune zu erfassen und zu steuern. Aber nicht jeder Verkäufer ist ein guter Verkäufer, und obendrein schwindet in Zeiten der vordringenden maschinellen Intelligenz das Vertrauen in den schwachen Menschen. Deshalb bietet die US-Firma Emotient eine App für die Datenbrille von Google an, sie tastet die Gesichter der Gegenüber ab: „Verkäufer können sie nutzen, um die Reaktionen der Kunden zu messen und ihre eigene Reaktion dann darauf abzustimmen.“

Echter Schmerz oder gespielter?

Diese Drohung ist nicht hohl, hinter Emotient steht u. a. Marian Stewart Bartlett, sie arbeitet im Hauptberuf am Institute for Neural Computation der University of California und hat dort gerade ein Computersystem entwickelt, das einem schmerzverzerrten Gesicht ablesen kann, ob der Schmerz echt ist oder nicht. Dazu kamen Testpersonen im Labor in zwei verschiedene Situationen: Einmal hielten sie ihren Arm eine Minute lang in eiskaltes Wasser, das andere Mal sollten sie nur so tun, als ob sie es täten und es ihnen wehtue. Beides wurde mit Video aufgezeichnet, die Bilder wurden dann menschlichen Beobachtern und einem lernfähigen Gesichtsvermessungsprogramm vorgelegt. Menschen tippten in der Hälfte der Fälle richtig – also nicht besser als zufällig –, das Programm brachte es auf 85 Prozent, die Differenz zeigt sich vor allem am Mund, simulierter Schmerz verzerrt ihn zu regelmäßig. (Current Biology, 21. 3.)

Bartlett erweitert das Prinzip in ihrer App für die Google-Brille auf andere Gesichtsausdrücke, und man kann nur hoffen, dass sie bald auch eine App anbietet, mit dem Kunden Verkäuferlächeln durchschauen. Das wird schwierig, denn zum Lächeln braucht man nur einen einzigen Muskel – beim Lächeln des Mundes, die Falten um die Augen sind komplexer –, er aber kann gleich doppelt täuschen: Es kann ein „falsches“ Lächeln sein, das eine positive Emotion vormacht, wenn gar keine da ist, und es kann ein „klägliches“ Lächeln sein, das überdecken soll, dass es einem in Wahrheit ganz schlecht geht. (Journal of Nonverbal Behavior, 6, S. 238)

Diese Beobachtung stammt vom US-Anthropologen und Psychologen Paul Ekman, dem Großmeister der Mimik, er hat es zum Moviestar gebracht – in der Fernsehserie „Lie to Me“ tritt ein Dr. Cal Lightman als weltbester menschlicher Lügendetektor auf, hinter ihm steht Ekman –, er hat auch kommerzielle Programme im Angebot, die Sicherheitspersonal etwa auf Flughäfen darin schulen sollen, Gesichtern finstere Absichten abzulesen: terroristische. Und er hat in den 1970er- und 1980er-Jahren das Fundament gelegt, auf dem Bartlett nun ihre Maschinenintelligenz hochzüchtet: Es heißt Facial Acting Coding System (FACS) und nimmt alle Muskeln in den Blick, die im Gesicht bewegbar sind, laut Ekman sind es 43, mit ihnen sind über 10.000 Ausdrücke erreichbar (theoretisch, in der Praxis weniger, weil die Muskeln nicht frei voneinander bewegt werden können). Ekman hat sie, in Anlehnung an jahrtausendealte Klassifizierungen, auf sieben Typen reduziert – Gesichter können glücklich aussehen oder traurig, ängstlich oder ärgerlich, überrascht oder angewidert, verächtlich auch noch –, und er ist ein selbstsicherer Mann, erklärt in Interviews, ihm entgehe kein Gesichtsausdruck.

Und der Hass, das Entsetzen, die Scheu?

Aber wo bleiben unter den sieben denn der Hass, das Entsetzen, die Scheu? Und wo sind die Modulationen? Man kann ja von etwas angenehm und unangenehm überrascht sein. Diese Fragen kommen von Aleix Martinez (Ohio State University), auch er steht auf den Schultern von Ekman und seinen FACS, aber er hat bei Testpersonen eine viel größere Vielfalt gefunden, insgesamt 21 Gesichtsausdrücke (Pnas, 31. 3.). Im Unterschied zu den „Basic“-Typen – hier zählt Martinez sechs – nennt er sie „Compound Emotions“, und zu ihnen gehört etwa ein „glücklich überraschtes“ Gesicht oder ein „ärgerlich überraschtes“, je nachdem, wie die Überraschung war. Zu ihnen gehört auch die Mimik, bei der zusammengehende Emotionen in einem Wort beschrieben werden: Hass (Ekel und Ärger, mit Gewichtung auf Ärger), Entsetzen (auch Ekel und Ärger, aber mit Gewichtung auf Ekel), Scheu (Furcht und Überraschung).

Martinez hat nach eigenem Bekunden „ein ganz neues Forschungsfeld für Studien der Kognition und Kommunikation und für maschinelles Sehen“ geöffnet. Und Bartlett ergänzt, was es bald alles für Maschinen zu sehen geben soll: „Unser System kann eingesetzt werden, um wichtige Hinweise etwa auf die Gesundheit zu erhalten, auf Emotionen, Gedanken, auf den Ausdruck von Schläfrigkeit im Gesicht eines Autofahrers, auf den Ausdruck der Aufmerksamkeit im Gesicht von Schülern oder auf die Reaktion der Behandlung von psychischen Leiden.“

Keine Kommentare:

Kommentar veröffentlichen