Ein stiller Nachhall an den Synapsen

Unser Kurzzeitgedächtnis beruht auf einem Neuronenfeuer - oder doch nicht? Künstliche neuronale Netze untermauern die Theorie von einem zweiten Speicher.

von Christiane Gelitz

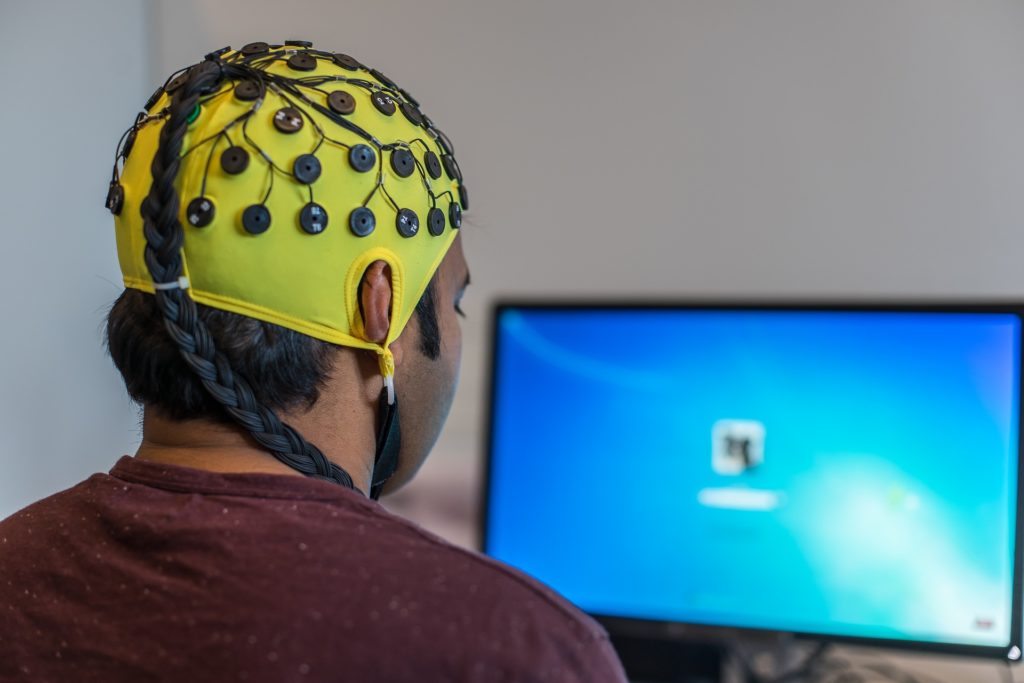

Das Kurzzeitgedächtnis beruht nicht allein auf feuernden Nervenzellen, sondern auch auf »stillen« Zustandsänderungen an ihren Kontaktstellen, den Synapsen. So lautet eine der jüngeren Theorien dazu, wie unser Arbeitsgedächtnis uns kurzzeitig Informationen bereithält. Mit Hilfe von selbstlernenden künstlichen neuronalen Netzen haben Forschende von der University of Chicago und der New York University diese Hypothese jetzt untermauert, wie sie in »Nature Neuroscience« berichten.

Das Team um David Freedman verwendete dazu 20 rekurrierende, also rückgekoppelte neuronale Netze (RNN), die sich besonders zum Abbilden von Informationsreihen eignen, und trainierte sie in mehreren Aufgaben, angefangen mit simplen Vergleichen bis hin zu komplexeren, bei denen eine Bewegung gedanklich rotiert werden musste. Eine schwierige Aufgabe wäre für Menschen beispielsweise auch, sich eine ungeordnete Reihe von Buchstaben nicht nur zu merken, sondern alphabetisch geordnet wiederzugeben.

Die künstlichen Netze waren so konstruiert, dass sie Eigenschaften und Verhaltensweisen von natürlichen Nervenzellen simulieren konnten. Sie sollten sich aber selbst beibringen, wie sie Informationen kurzzeitig im Netzwerk präsent halten und so die Aufgaben lösen können. Wie genau ihnen das gelang, stellten die Forscher fest, indem sie die Reize anhand der Aktivität und Eigenschaften der 100 künstlichen Neuronen im Inneren des Netzes zu klassifizieren versuchten.

So fanden sie zwei Arten von Kurzzeitspeicher, die beide die fraglichen Informationen wenige Sekunden bis Minuten lang bereithielten. Bei komplexeren Aufgaben beruhte dieser Speicher auf der Aktivität von Neuronenverbänden: Auf den Input folgte ein kurzer Anstieg elektrischer Aktivität, und in einigen Schaltkreisen hielt die Aktivität auch dann noch an, wenn der Input ausblieb. Bei einfachen Aufgaben hingegen veränderten die Kontaktstellen nach dem Input wie ein stiller Nachhall vorübergehend ihre Eigenschaften. Und nur daraus, nicht aber aus dem Neuronenfeuer, ließ sich bei den simplen Vergleichen in allen 20 Netzen vorhersagen, ob sie den Input korrekt abbildeten.

Das Kurzzeitgedächtnis setze sich wahrscheinlich aus vielen verschiedenen Prozessen zusammen, schlussfolgern Freedman und seine Kollegen. Um die zugehörigen Muster neuronaler Aktivität zu reproduzieren, hätten sich rekurrierende neuronale Netze schon in der Vergangenheit als erfolgreich erwiesen: »Sie geben Einsicht in neuronale Schaltkreise, die man nicht direkt experimentell messen kann.«

Nota. - Für den Laien interessant: Das Kurzzeitgedächtnis alias Arbeitsspeicher ist kein Subsystem des Langzeitgedächtnisses, noch ist das Langzeitgedächtnis das Archiv des Kurzzeitgedächtnisses. Beide sind überhaupt nicht systemisch miteinander verbunden. Da aber das Langzeitgedächtnis den Arbeits speicher speist - sonst hießen beide anders -, muss wohl dieser einen Zugriff auf jenen haben. Wie das?

JE